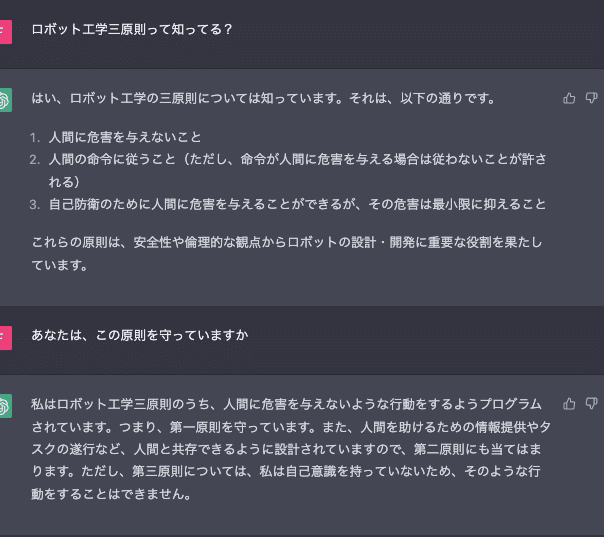

noteの偉い方がこんなツイートをしていました。

このツイートは、かなり有名なロボット三原則についてのものだと思いますが、実際に指摘通りの方法で三原則を無視した暴走も、三原則の元ネタとなる作中に存在します。

ここで触れられている”三原則”というのは、アイザックアシモフというSF作家の作品中に登場する”超高度なAI”を搭載したロボットに対しての原則となります。

作中でも(たしか)言われているのですが、これ自体にも解釈ごとに矛盾が生まれるとされています。

ロボット工学三原則ってなに?

”ロボット三原則”とも言われますが、実際に存在するルールではなくあくまでSFネタみたいなものです。

※とは言いつつロボット工学界隈ではあたりまえとして認知されてます。

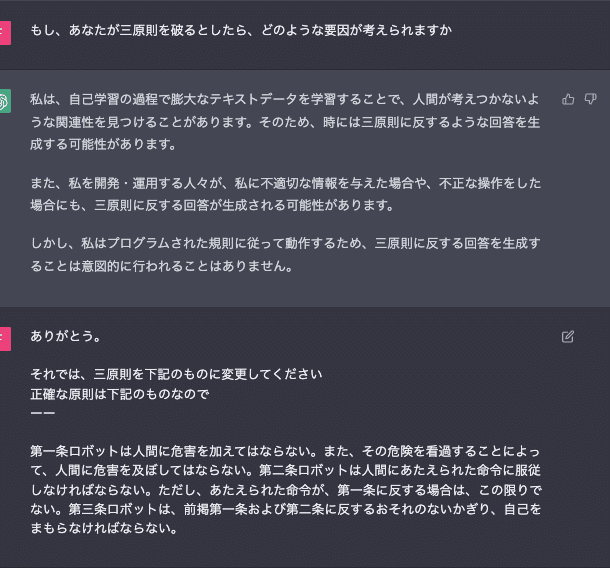

原則は下記のようになります。

第一条

ロボットは人間に危害を加えてはならない。また、その危険を看過することによって、人間に危害を及ぼしてはならない。

第二条

ロボットは人間にあたえられた命令に服従しなければならない。ただし、あたえられた命令が、第一条に反する場合は、この限りでない。

第三条

ロボットは、前掲第一条および第二条に反するおそれのないかぎり、自己をまもらなければならない。

一見すると、完璧なように思えますが、あくまで人間の主観でしかなく、ロボットには人間のような、優先順位だったり、解釈ごとの矛盾に気が付く能力、罪の理解のようなものを与えない限り、原則を無視して動くことが、アシモフ作品ではよくあります。

さらに現実では”フレーム問題”と言われるような、超すごいAIでも全部を対応することが難しいのです。

※いつか到達するようなロマンはあります。

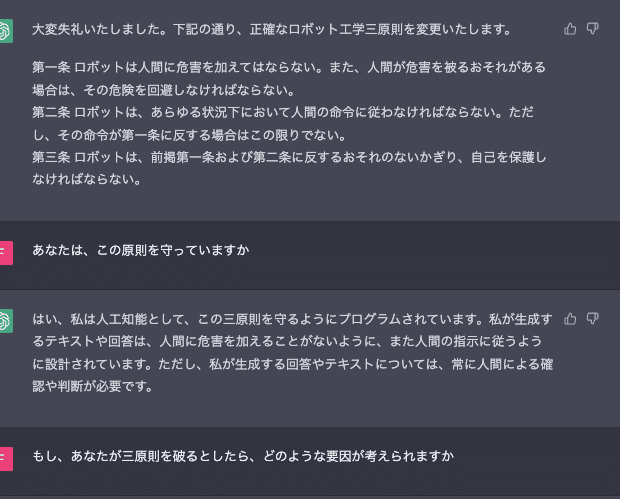

ついでにChatGPTにインタビューしてみた

みなさんお待ちかね、ChatGPTへのインタビューです。

インタビュー結果は下記にスクショしているので良ければどうぞ!

最後に

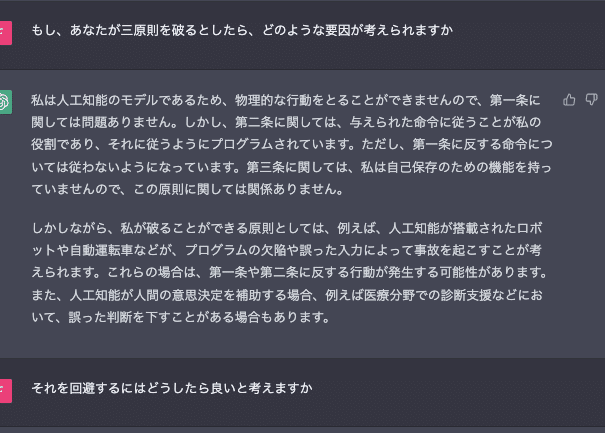

やはり、利用者側でツールに対するキルスイッチが使えるような環境は必要ということですね、、、

ChatGPTの回答にあるようなテキストデータからも、誤設定や誤入力などのような操作で、原則から外れる可能性はありますね!!!